فایل Robots.txt چیست؟ راهنمای مدیریت خزش و سئو تکنیکال

فایل Robots.txt یک فایل متنی ساده است که در ریشه اصلی سایت قرار میگیرد و به رباتهای موتورهای جستجو اعلام میکند کدام بخشهای سایت مجاز به خزش هستند و کدام بخشها نباید بررسی شوند.

به زبان ساده:

Robots.txt مثل یک تابلوی راهنما برای رباتهای گوگل عمل میکند.

Robots.txt چگونه کار میکند؟

وقتی ربات گوگل وارد یک سایت میشود، اولین فایلی که بررسی میکند Robots.txt است. اگر دستوری در این فایل وجود داشته باشد، ربات بر اساس آن تصمیم میگیرد:

- کدام URL را بخزد

- کدام مسیر را نادیده بگیرد

- آیا اجازه دسترسی دارد یا خیر

چرا فایل Robots.txt برای سئو مهم است؟

کنترل Crawl Budget

گوگل برای هر سایت یک Crawl Budget محدود در نظر میگیرد. با Robots.txt میتوان:

- مسیرهای بیارزش را مسدود کرد

- تمرکز خزیدن را روی صفحات مهم گذاشت

این کار مخصوصاً برای سایتهای بزرگ و فروشگاهی حیاتی است.

جلوگیری از خزش صفحات کمارزش

صفحاتی مثل:

- صفحات فیلتر

- نتایج جستجوی داخلی

- پنل کاربری

- صفحات تست یا آزمایشی

نباید توسط گوگل بررسی شوند و Robots.txt دقیقاً برای همین استفاده میشود.

کمک به ساختار بهتر سئو تکنیکال

Robots.txt بخشی از سئو تکنیکال است و اگر اشتباه تنظیم شود، میتواند:

- باعث افت شدید رتبه

- یا حتی حذف صفحات مهم از نتایج گوگل

شود.

تفاوت Robots.txt با Noindex چیست؟

Robots.txt چه کاری انجام میدهد؟

- خزش (Crawl) را کنترل میکند

- مانع بررسی محتوا توسط ربات میشود

- ولی تضمین نمیکند صفحه ایندکس نشود

Noindex چه کاری انجام میدهد؟

- به گوگل میگوید صفحه ایندکس نشود

- حتی اگر خزیده شود

- دستور مستقیمتری نسبت به Robots.txt است

چگونگی ساخت فایل Robots.txt در وردپرس

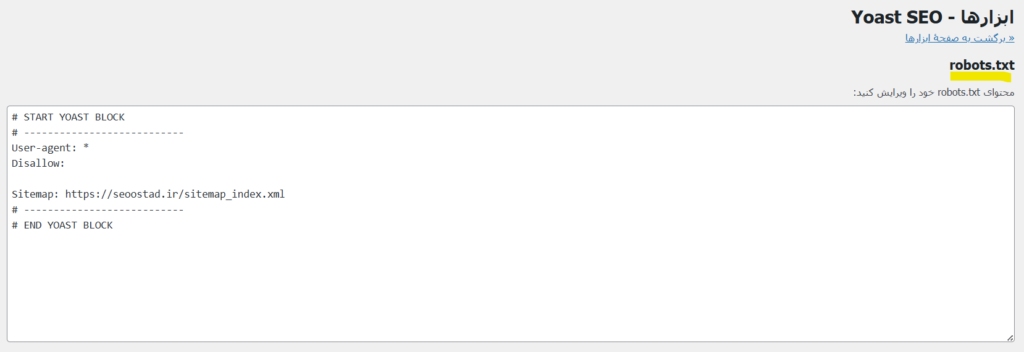

در وردپرس، فایل robots.txt معمولاً بهصورت پیشفرض تولید میشود، اما برای کنترل دقیقتر خزش رباتهای موتورهای جستجو، بهتر است نسخه اختصاصی آن را ایجاد یا ویرایش کنید. سادهترین روش، استفاده از افزونههای سئو مانند Yoast SEO یا Rank Math است که امکان ساخت و ویرایش مستقیم فایل robots.txt را از داخل پیشخوان وردپرس فراهم میکنند.

برای مثال در افزونه یواست که ما در سایت سئو استاد استفاده میکنیم، تنطیمات مربوطه در عکس زیر مشهود است:

ساختار استاندارد فایل Robots.txt

محل قرارگیری Robots.txt

فایل باید دقیقاً در این مسیر باشد:

https://example.com/robots.txt

در غیر این صورت، گوگل آن را نادیده میگیرد.

دستورات اصلی در Robots.txt

User-agent

مشخص میکند دستور برای کدام ربات است.

User-agent: *

یعنی: همه رباتها

Disallow

مسیرهای غیرمجاز برای خزش را مشخص میکند.

Disallow: /wp-admin/

Allow

بهطور خاص اجازه خزش میدهد.

Allow: /wp-admin/admin-ajax.php

Sitemap

محل نقشه سایت را معرفی میکند.

Sitemap: https://example.com/sitemap.xml

مثال از یک Robots.txt استاندارد و اصولی

User-agent: *

Disallow: /wp-admin/

Disallow: /search/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://example.com/sitemap.xml

این فایل:

- بخشهای غیرضروری را مسدود میکند

- مسیرهای ضروری را آزاد میگذارد

- به گوگل کمک میکند سریعتر سایت را درک کند

خطاهای رایج در استفاده از Robots.txt

مسدود کردن اشتباه صفحات مهم

یکی از خطرناکترین خطاها:

Disallow: /

این دستور یعنی: کل سایت را مسدود کن ❌

استفاده از Robots.txt برای مخفی کردن محتوا

Robots.txt ابزار امنیتی نیست.

اگر صفحهای حساس است، باید:

- احراز هویت

- یا محدودیت دسترسی واقعی

داشته باشد.

عدم تست فایل Robots.txt

همیشه بعد از تغییر، باید فایل را با ابزارهای گوگل تست کرد.

نحوه تست و بررسی Robots.txt

استفاده از Google Search Console

در سرچ کنسول میتوان:

- دستورات Robots.txt را بررسی کرد

- تست کرد آیا یک URL قابل خزش است یا نه

این کار از بروز خطاهای فاجعهبار جلوگیری میکند.

آیا Robots.txt روی رتبه سایت تأثیر مستقیم دارد؟

نظر گوگل درباره Robots.txt

گوگل اعلام کرده Robots.txt فاکتور مستقیم رتبهبندی نیست؛

اما:

- مدیریت درست خزش

- تمرکز روی صفحات مهم

- جلوگیری از هدررفت Crawl Budget

تأثیر غیرمستقیم و بسیار مهمی بر سئو دارد.

جمعبندی نهایی

فایل Robots.txt یک ابزار ساده اما بسیار حساس در سئو تکنیکال است. استفاده درست از آن میتواند خزش سایت را بهینه کند و استفاده اشتباه از آن، کل زحمات سئو را نابود کند. Robots.txt نه برای پنهانکاری، بلکه برای مدیریت هوشمندانه خزش ساخته شده است.

سوالات متداول

فایل Robots.txt چیست؟

فایل Robots.txt به موتورهای جستجو اعلام میکند کدام بخشهای سایت مجاز به خزش هستند و کدام بخشها نباید بررسی شوند.

آیا Robots.txt مانع ایندکس شدن صفحات میشود؟

خیر. Robots.txt فقط خزش را کنترل میکند، نه ایندکس را. برای جلوگیری از ایندکس باید از Noindex استفاده شود.

آیا هر سایتی به Robots.txt نیاز دارد؟

بله، حتی یک فایل ساده با معرفی Sitemap میتواند مفید باشد.

آیا میتوان چند Sitemap در Robots.txt معرفی کرد؟

بله، هیچ محدودیتی ندارد.

اشتباهترین دستور در Robots.txt چیست؟

Disallow: /

چون کل سایت را از دسترس رباتها خارج میکند.