فایل robots.txt چیست؟ نحوه تنظیم اصولی آن بر اساس سئو

یکی از ساده ترین فایل هایی که در سایت ها قرار داده می شود فایل Robots.txt است که اهمیت ویژه ای برای سئو سایت دارد. همچنین پیکربندی نادرست این فایل می تواند به سرعت، سئو سایت را خراب کرده و مانع دسترسی موتورهای جستجو و خزنده های آن ها به محتوای سایت شود. حتی ممکن است متخصصان با تجربه و خبره سئو نیز در پیکربندی فایل Robots.txt اشتباه کنند که منجر به هزینه هایی برای سایت خواهد شد. در این مقاله از سایت سئواستاد به طور مفصل در مورد نحوه تنظیم اصولی فایل Robots.txt بر اساس سئو صحبت می کنیم.

فایل robots.txt چیست؟

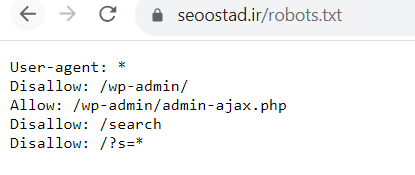

برای مدیریت و کنترل نحوه دسترسی ربات های گوگل به صفحات سایت می توان فایل متنی Robots.txt را روی سرور سایت قرار داد. این فایل شامل قوانینی است که به خزنده های موتورهای جستجو می فهماند که کدام صفحات باید خزیده شوند و کدام یک نباید ایندکس شوند. محل قرارگیری فایل Robots.txt در دایرکتوری ریشه سایت است؛ به عنوان مثال اگر دامنه سایت domain.com باشد این فایل باید در مسیر domain.com/robots.txt بارگذاری گردد.

چگونگی ساخت فایل robots.txt در وردپرس

برای ساخت robots.txt در وردپرس باید در مرحله اول در هاست سایت روی File Manager کلیک کرد تا به فایل های هاست دسترسی داشت. در مرحله بعد وارد مسیر /public_html/ شده تا وارد مسیر نصب وردپرس شد. در گام سوم باید با استفاده از برنامه notepad یا سایر نرم افزارهای ویرایشگر متن، فایلی به نام robots.txt ایجاد کرد سپس بر روی دکمه آپلود در فایل منجر کلیک نموده و فایل را در این مسیر قرار دهید. روش دیگر ساخت این فایل به این صورت است که روی FILE+ کلیک کرده و در پنجره باز شده نام فایل را در فیلد New File Name وارد نمایید. سپس برای ساخته شدن فایل robots.txt روی دکمه Create New File کلیک کنید.

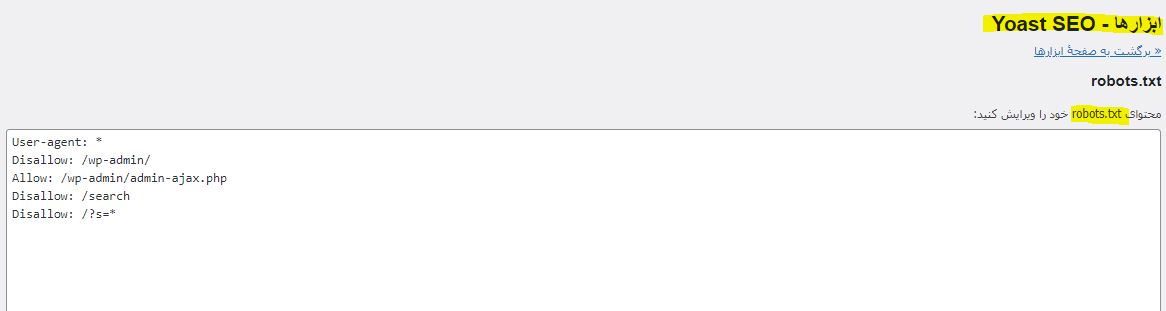

روش ساده تری نیز وجود دارد که با استفاده از افزونه یوست انجام می شود. کافی است کُد را داخل کادر سفید مربوطه قرار دهید. به همین سادگی? ( البته در آپدیت های جدید افزونه یوست سئو، این امکان برداشته شده است).

نحوه کار فایل robots.txt

موتورهای جستجو از خزنده ها برای پیدا کردن محتوای سایت با هدف ایندکس و رتبه بندی استفاده می کنند. عملیات ایندکس محتوای سایت توسط خزنده ها طی چند مرحله انجام می شود.

۱. در خزنده ها لیستی از آدرس ها یا URL ها وجود دارند که شامل سایت های جدید و سایت های قبلا شناخته شده ای هستند که باید توسط این خزنده ها بررسی شوند.

۲. در ابتدای ورود خزنده ها به سایت، آنها در دایرکتوری ریشه سایت به دنبال فایل robots.txt می گردند.

۳. در صورتی که در دایرکتوری سایت هیچ فایل robots.txt موجود نباشد آن ها به طور آزادانه صفحات سایت را می خزند. اما اگر فایل robots.txt معتبری در سایت باشد آن ها در داخل آن به دنبال دستورالعملی هستند که براساس آن سایت را بخزند.

۴. اگر ربات های موتورهای جستجو به هر دلیلی صفحات سایت را نتوانند بخزند، در آن صورت صفحات ایندکس نشده و در نتایج گوگل قابل مشاهده نخواهد بود.

نحوه تنظیم اصولی فایل robots.txt براساس سئو

دو دستور User-agent و Disallow برای پیکربندی و تنظیم فایل robots.txt وجود دارد که در ادامه به توضیح هر یک می پردازیم.

- دستور User-agent: با استفاده از این دستور می توان تعیین کرد که چه نوع رباتی به دایرکتوری های تعیین شده در هاست می تواند دسترسی داشته باشد.

- دستور Disallow: با استفاده از این دستور تعیین می شود که ربات های گوگل به چه مسیرهایی در هاست نمی توانند دسترسی داشته باشند.

برای اینکه فایل robots.txt بر اساس سئو پیکربندی شود باید چند نکته را مورد توجه قرار داد.

به طور کلی فایل هایی که در دستور disallow قرار داده می شوند توسط ربات های گوگل خزیده نمی شوند.

دستور disallow برای جلوگیری از نمایش اطلاعاتی مثل اطلاعات هویتی و خصوصی کاربران روش کارآمدی نیست؛ زیرا احتمال دارد از سایر صفحات به این صفحه لینک داده شود و ربات های گوگل توسط این لینک ها به صفحه اطلاعات برسند و آن را بخزند و ایندکس کنند.

صفحه ای که در برابر خزیدن مسدود شده باشد ممکن است همچنان توسط ربات ها ایندکس شود.

ربات های گوگل را نمی توان در پیروی کردن از قوانین موجود در فایل robots.txt مجبور کرد!

اهمیت ایجاد فایل robots.txt برای سئو سایت

فایل Robots.tx یک فایل بهینه شده است که از جنبه های مختلفی برای سایت مفید خواهد بود؛ به طوری که این فایل می تواند به مدیر سایت در بهینه کردن بودجه خزش کمک نماید. به این دلیل که خزنده های گوگل منابع محدود داشته و در خزش تعداد URLهای یک سایت محدودیت دارند، اگر سهمیه خزش خود را به صفحات کم اهمیت اختصاص دهند احتمال دارد نتوانند صفحات با ارزش تر را بخزند.

با استفاده از فایل robots.txt در سایت می توان مانع از خزیدن صفحات با کیفیت کم توسط ربات های گوگل شد. چنانچه در سایتی صفحات با کیفیت پایین زیادی وجود داشته باشد می تواند از خزیدن ربات های گوگل برای خزیدن صفحات با کیفیت بالا جلوگیری کند.

اهمیت دیگر فایل robots.txt امکان مشخص کردن نقشه سایت XML توسط این فایل است؛ نقشه سایت نیز یک فایل متنی شامل فهرستی از آدرس هایی از صفحات سایت است که می خواهیم توسط موتورهای جستجو ایندکس شوند. وقتی که آدرس نقشه سایت XML در فایل robots.txt قرار داده می شود، ربات های گوگل راحت تر می توانند این نقشه را پیدا کنند.

فایل robots.txt از ایندکس چه صفحاتی جلوگیری می کند؟

فایل robots.txt می تواند مانع ایندکس شدن صفحات خاص، تگ ها و دسته بندی ها شود؛ همچنین از خزش موارد زیر نیز جلوگیری می کند.

- ممانعت از خزش فیلتربندی صفحات محصول مثل فیلترهای قیمت، رنگ، قدیمی ترین، جدیدترین و…

- ایندکس نکردن صفحاتی از سایت که با جستجو در داخل سایت ایجاد می شوند.

- جلوگیری از خزش همه صفحات ادمین و پنل سایت، صفحه پروفایل کاربران سایت و صفحات چت

- ایندکس نکردن بعضی از فایل های قالب سایت که نیازی نیست گوگل آن ها را ببیند.

جمع بندی

ساخت فایل Robots.txt بسیار راحت است که تنظیمات آن باید فقط یکبار انجام شود و سپس می تواند بسته به نیاز خود آن را تغییر دهید. در صورتی که پیکربندی این فایل به درستی و بدون اشتباه انجام شود تاثیر بسیار خوبی روی عملیات ایندکس سایت خواهد داشت. هنگامی که به صورت بهینه، ربات های موتورهای جستجو بودجه خزش را در سایت مصرف کنند؛ در این صورت تغییرات محتوایی سایت توسط گوگل سریع تر دیده می شود.

مقاله پیشنهادی: ریدایرکت چیست؟